OpenAI lança GPT-4.5: mais caro e talvez o último de sua linhagem

Questiona-se se o custo compensa o que o LLM oferece. Mais: Bun com recursos para frontend, Claude e Google lançam IAs de código e Doom rodando no sistema de tipos do TypeScript.

A OpenAI lançou oficialmente o GPT-4.5, seu maior e mais avançado modelo para chat até o momento. Inicialmente disponível para usuários do plano ChatGPT Pro ($200/mês) e desenvolvedores em níveis pagos da API, a ferramenta será gradualmente liberada para assinantes Plus e Team na próxima semana, e para clientes Enterprise e Edu na semana seguinte.

O GPT-4.5 representa um avanço significativo no aprendizado não supervisionado, incorporando mais poder computacional e dados que seus antecessores. Durante os testes, a OpenAI relata que interagir com ele "parece mais natural", graças a uma base de conhecimento mais ampla, melhor compreensão da intenção do usuário e maior "inteligência emocional".

A empresa afirma que o modelo oferece respostas mais calorosas e intuitivas, compreendendo melhor sutilezas e expectativas implícitas. Ao contrário dos modelos de raciocínio como o OpenAI o1 e o3-mini, que trabalham as respostas passo a passo, o GPT-4.5 não "pensa" antes de responder, confiando em um aprendizado mais profundo de padrões para gerar respostas imediatas.

Em benchmarks de precisão como o SimpleQA, o GPT-4.5 alcançou 62,5% de acertos, superando o GPT-4o (38,2%) e o OpenAI o3-mini (15%). Mais importante, ele apresenta uma taxa de alucinação (respostas inventadas) de apenas 37,1%, consideravelmente menor que o GPT-4o (61,8%) e o o3-mini (80,3%). No entanto, em testes específicos de matemática e ciências, como AIME e GPQA, o modelo ainda fica atrás dos principais modelos de raciocínio.

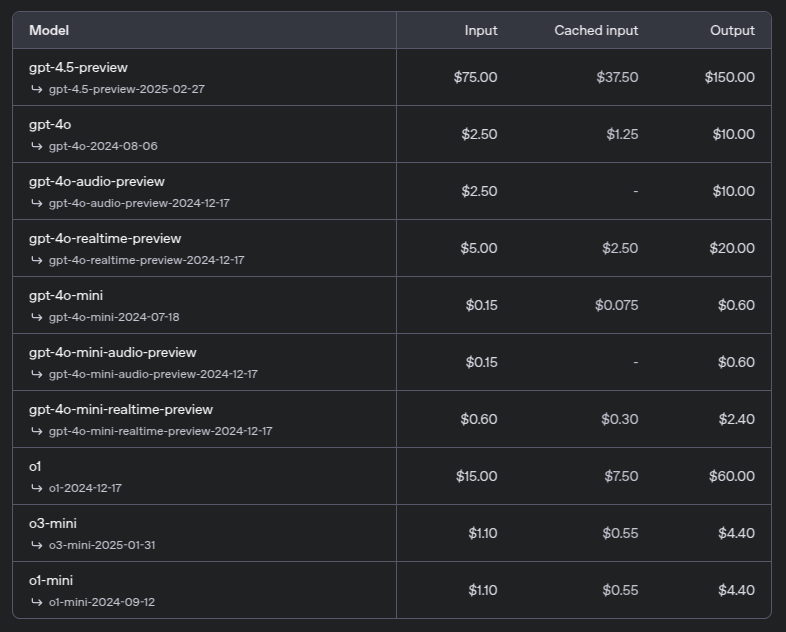

O custo operacional é um ponto crítico do novo modelo. Para desenvolvedores, o preço da API é substancialmente mais alto: $75 por milhão de tokens de entrada (aproximadamente 750.000 palavras) e $150 por milhão de tokens de saída. Em comparação, o GPT-4o custa apenas $2,50 por milhão de tokens de entrada e $10 por milhão de tokens de saída. Isso representa um aumento de 30 vezes no custo de entrada e 15 vezes no custo de saída.

Esses altos custos levaram a OpenAI a questionar publicamente a viabilidade de manter o GPT-4.5 disponível na API a longo prazo. Para alguns especialistas, como Waseem Alshikh da Writer, "jogar mais poder de computação e dados em um modelo pode fazê-lo soar mais fluido, mas não é uma mudança de jogo" e "o esforço não vale a pena quando se consideram os custos energéticos e o fato de que a maioria dos usuários não notará a diferença no uso diário".

O GPT-4.5 pode representar o fim de uma era. Sam Altman, CEO da OpenAI, indicou que este será o último lançamento da linha "clássica" da empresa, e que o GPT-5, previsto para mais tarde este ano, será um híbrido que combina um modelo de linguagem de propósito geral com um modelo de raciocínio.

A comunidade científica vem questionando se as "leis de escala" do pré-treinamento continuarão válidas. Ilya Sutskever, cofundador e ex-cientista-chefe da OpenAI, declarou em dezembro que "alcançamos o pico de dados" e que "o pré-treinamento como conhecemos inquestionavelmente terminará".

O GPT-4.5 parece confirmar essa tendência. Apesar de impressionar em alguns aspectos, o modelo não entrega os saltos quânticos de desempenho vistos nas gerações anteriores. Isso sugere que simplesmente aumentar o poder computacional e o volume de dados pode estar encontrando seus limites, levando a indústria a explorar abordagens alternativas, como os modelos de raciocínio que a OpenAI inaugurou e a chinesa DeepSeek surpreendeu ao melhorar e dar de graça aos usuários.

O GPT-4.5 está disponível desde 27 de fevereiro em acesso antecipado para assinantes do ChatGPT Pro, com lançamento previsto para usuários Plus e Team na próxima semana. Desenvolvedores interessados podem acessá-lo via API de Chat Completions, Assistants ou Batch, desde que estejam em planos pagos. Mais no anúncio oficial.

Bun 1.2.3 chega com foco no desenvolvimento frontend

O runtime JavaScript Bun acaba de lançar a versão 1.2.3 com foco renovado no desenvolvimento frontend. A atualização traz um servidor de desenvolvimento com hot reloading ultrarrápido, suporte nativo a React e um sistema de rotas integrado para Bun.serve(). Com o novo comando bun ./index.html, desenvolvedores podem iniciar aplicações frontend sem configurações adicionais. A versão também adiciona importantes melhorias no sistema SQL, com suporte a queries múltiplas e fragmentos SQL, além de resolver 128 bugs que afetavam a compatibilidade com Node.js, especialmente nas funções de Buffer e Node-API. Mais no anúncio oficial.

Claude 3.7 e Code: IA com raciocínio híbrido e ferramenta para devs

Mais lançamentos na IA: Anthropic lançou o Claude 3.7 Sonnet, primeiro modelo híbrido de raciocínio do mercado, capaz de alternar entre respostas rápidas e pensamento passo a passo. A novidade vem acompanhada do Claude Code, ferramenta de linha de comando que permite delegar tarefas de engenharia diretamente do terminal. Em prévia, o assistente consegue pesquisar código, editar arquivos, escrever testes e até fazer commits no GitHub. Nos testes iniciais, o Claude Code completou tarefas em uma única passagem que normalmente levariam mais de 45 minutos de trabalho manual. Mais no anúncio oficial.

Google lança versão gratuita do Gemini Code Assist com limites generosos

E o Google não poderia ficar atrás: a bigtech disponibilizou a versão gratuita do Gemini Code Assist para desenvolvedores individuais, estudantes e freelancers. A ferramenta oferece recursos de assistência à codificação nas principais IDEs como VSCode e JetBrains, com limites de uso altos: até 180 mil completações de código por mês, 90 vezes mais que outros assistentes gratuitos do mercado. O assistente, que usa o modelo Gemini 2.0 otimizado para código, também inclui análise de código no GitHub para repositórios públicos e privados, com suporte a guias de estilo personalizados. Para usar o serviço, basta ter uma conta Gmail pessoal. Mais no blog do Google.

Mastra: novo framework TypeScript para agentes de IA

A equipe do Gatsby lançou o Mastra, framework para desenvolvimento de agentes de IA em TypeScript. A ferramenta permite criar, gerenciar e implementar agentes inteligentes com funcionalidades como memória persistente, orquestração de fluxos de trabalho e sistemas RAG (Retrieval Augmented Generation). Segundo seus desenvolvedores, o framework proporciona uma experiência de desenvolvimento limpa e intuitiva para quem prefere trabalhar com TypeScript em vez de Python. Mais no site oficial e no repo do projeto.

Doom rodando no sistema de tipos do TypeScript

Dimitri Mitropoulos, do Michigan TypeScript, conseguiu rodar o clássico jogo Doom de 1993 inteiramente dentro do sistema de tipos do TypeScript. O projeto exigiu o processamento de 177 terabytes de tipos durante 12 dias apenas para renderizar o primeiro quadro do jogo. Mitropoulos construiu uma máquina virtual completa dentro do sistema de tipos, com RAM, disco, pilha de chamadas e ponteiros de memória, implementando as 116 instruções de WebAssembly necessárias. Para isso, precisou modificar o compilador do TypeScript, removendo salvaguardas como o limite de pilha e o tamanho para uniões e tuplas. O código está disponível no GitHub do projeto. Mais aqui.

Obrigado por acompanhar a BeTalent Academy. Se gostou, compartilhe e deixe um comentário. Até a próxima semana, com mais uma edição!